在数字化时代,处理大数据已成为我们日常生活中不可或缺的一部分。无论是数据分析、日志分析还是内容创作,高效地读取和处理大文件都显得尤为重要。今天,我们就来探讨如何在.NET框架中高效地读取1GB大小的超大型文本文件。

一、面对大数据的挑战

在处理达到GB级别的超大文本文件时,传统的读取方法往往效率低下,甚至可能因为内存不足而导致程序崩溃。因此,我们需要寻找一种更为高效的方法来应对这一挑战。

二、MemoryMappedFile的优势

在.NET中,MemoryMappedFile类为我们提供了一种全新的解决方案。它允许我们将大文件映射到内存中,从而实现高效的文件读取操作。与传统的StreamReader相比,MemoryMappedFile在处理大文件时具有显著的性能优势。

三、如何使用MemoryMappedFile读取文件

首先,我们需要创建一个MemoryMappedFile实例。这可以通过调用MemoryMappedFile.CreateFromFile方法来实现。该方法需要指定文件路径、文件模式以及文件长度等信息。

MemoryMappedFile mmf = MemoryMappedFile.CreateFromFile(filePath, FileMode.Open, null, fileLength);

接下来,我们可以利用MemoryMappedFile的CreateViewAccessor方法创建一个视图访问器。通过这个访问器,我们可以直接访问文件的内容,而无需将其全部读入内存。

四、优化读取过程

为了进一步提高读取效率,我们可以使用缓冲区来优化读取过程。例如,我们可以创建一个固定大小的缓冲区,并利用StreamReader的ReadBlock方法来分块读取文件内容。这样可以减少磁盘访问操作的次数,从而提高读取性能。

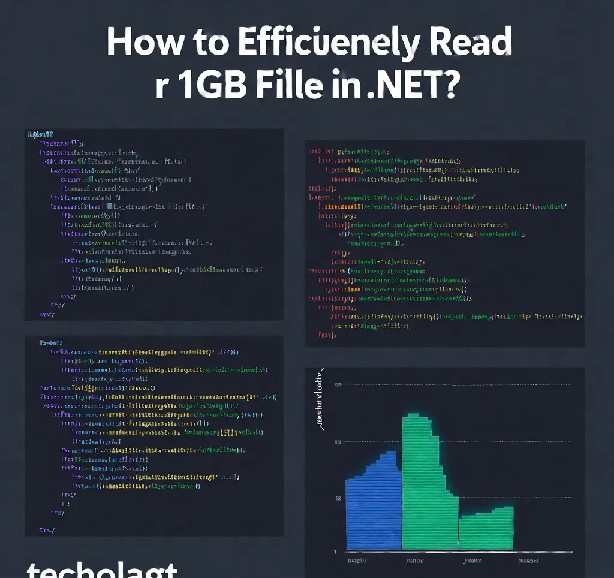

五、示例代码

下面是一个使用MemoryMappedFile和StreamReader优化读取过程的示例代码:

using (MemoryMappedFile mmf = MemoryMappedFile.CreateFromFile(filePath, FileMode.Open, null, fileLength))

using (StreamReader sr = new StreamReader(filePath))

{

const int bufferSize = 4096;

char[] buffer = new char[bufferSize];

int charsRead;

while ((charsRead = sr.ReadBlock(buffer, 0, buffer.Length)) != 0)

{

// 处理缓冲区中的数据

string data = Encoding.UTF8.GetString(buffer, 0, charsRead);

// 进行进一步的数据处理和分析

}

}

六、总结

通过使用MemoryMappedFile类和缓冲区优化读取过程,我们可以在.NET中高效地读取1GB大小的超大型文本文件。这种方法不仅提高了读取效率,还减少了内存消耗,使得大文件处理变得更加轻松和可靠。希望本文能为您在处理大数据时提供有益的参考和帮助。

七、更多精彩内容等你来发现

除了本文所介绍的内容外,PHP中文网还有更多关于高效处理大数据的文章等待您的探索。无论是文件压缩、数据加密还是其他相关主题,我们都将为您带来最前沿的技术资讯和实用的解决方案。请持续关注我们的网站,共同开启智慧科技之旅!

在处理大数据时,我们不仅要关注性能的提升,还要兼顾代码的可读性和可维护性。因此,在选择技术方案时,我们需要综合考虑各种因素,选择最适合自己需求的方案。希望本文能为您提供一些有益的启示和帮助。

声明:

1、本博客不从事任何主机及服务器租赁业务,不参与任何交易,也绝非中介。博客内容仅记录博主个人感兴趣的服务器测评结果及一些服务器相关的优惠活动,信息均摘自网络或来自服务商主动提供;所以对本博客提及的内容不作直接、间接、法定、约定的保证,博客内容也不具备任何参考价值及引导作用,访问者需自行甄别。

2、访问本博客请务必遵守有关互联网的相关法律、规定与规则;不能利用本博客所提及的内容从事任何违法、违规操作;否则造成的一切后果由访问者自行承担。

3、未成年人及不能独立承担法律责任的个人及群体请勿访问本博客。

4、一旦您访问本博客,即表示您已经知晓并接受了以上声明通告。

本站资源仅供个人学习交流,请于下载后24小时内删除,不允许用于商业用途,否则法律问题自行承担。

Copyright 2005-2024 yuanmayuan.com 【源码园】 版权所有 备案信息

声明: 本站非腾讯QQ官方网站 所有软件和文章来自互联网 如有异议 请与本站联系 本站为非赢利性网站 不接受任何赞助和广告