在现代电力电子技术中,Buck-Boost电路因其在电压升降压转换中的广泛应用而备受关注。然而,传统的控制方法如PID控制器在面对复杂负载变化和环境不确定性时,往往表现出局限性。近年来,强化学习(Reinforcement Learning, RL)技术的引入,为电路控制带来了革命性的变革。本文将探讨基于PPO(Proximal Policy Optimization)强化学习算法的Buck-Boost电路控制系统在MATLAB中的仿真实现,并与经典的PID控制器进行对比分析。

强化学习是一种通过智能体与环境交互来学习最优行为策略的机器学习方法。PPO算法作为一种改进的策略梯度方法,通过限制策略更新的步长来避免过大的策略变化,确保学习过程的稳定性和效率。PPO算法通过引入剪切目标函数和重要性采样技术,有效地平衡了学习速度和策略的稳定性。

在MATLAB环境中,我们首先定义了Buck-Boost电路的数学模型,包括电感、电容、负载等参数。然后,设置了PPO算法的超参数,如学习率、批量大小、剪切参数等。仿真过程中,智能体通过与电路环境的交互,逐步调整策略以优化电压输出。

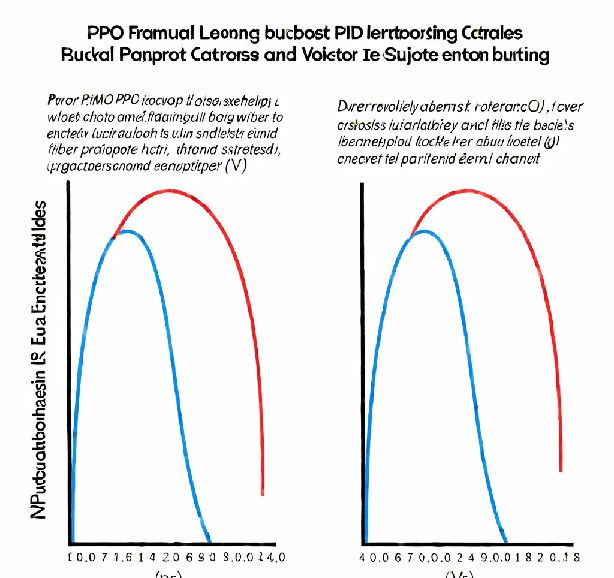

仿真结果显示,PPO控制的Buck-Boost电路在面对负载变化和输入电压波动时,表现出比PID控制更优的动态响应和稳定性。具体来说,PPO控制能够更快地调整到目标电压,减少了过冲和稳态误差。此外,PPO控制在处理非线性负载和突变负载时,表现出更强的适应性和鲁棒性。

传统的PID控制器通过比例、积分和微分三个部分来调节控制输出。虽然PID控制在许多应用中表现良好,但在处理复杂的非线性系统或需要自适应能力的场景中,其性能往往不如强化学习方法。通过MATLAB仿真,我们可以直观地看到PPO控制在响应速度和稳定性方面的优势。

通过本次MATLAB仿真研究,我们发现基于PPO的强化学习方法在Buck-Boost电路控制中具有显著的优势。特别是在需要高动态响应和鲁棒性的应用场景中,PPO控制系统展示了其潜力。未来,随着计算资源的增加和算法的进一步优化,强化学习在电力电子控制领域的应用前景将更加广阔。

未来的研究可以进一步探索如何将PPO算法与其他先进控制技术结合,如模糊控制或神经网络,以实现更高效的混合控制策略。此外,研究还可以扩展到其他类型的电力电子转换器,如Cuk、SEPIC等,以验证强化学习在不同电路拓扑中的适用性和效果。

通过本文的详细分析和仿真结果,我们不仅展示了PPO强化学习在Buck-Boost电路控制中的应用潜力,也为电力电子领域的控制技术提供了新的研究方向和方法。希望本文能激发更多研究者对这一领域的兴趣,推动电力电子控制技术的进一步发展。

声明:

1、本博客不从事任何主机及服务器租赁业务,不参与任何交易,也绝非中介。博客内容仅记录博主个人感兴趣的服务器测评结果及一些服务器相关的优惠活动,信息均摘自网络或来自服务商主动提供;所以对本博客提及的内容不作直接、间接、法定、约定的保证,博客内容也不具备任何参考价值及引导作用,访问者需自行甄别。

2、访问本博客请务必遵守有关互联网的相关法律、规定与规则;不能利用本博客所提及的内容从事任何违法、违规操作;否则造成的一切后果由访问者自行承担。

3、未成年人及不能独立承担法律责任的个人及群体请勿访问本博客。

4、一旦您访问本博客,即表示您已经知晓并接受了以上声明通告。

本站资源仅供个人学习交流,请于下载后24小时内删除,不允许用于商业用途,否则法律问题自行承担。

Copyright 2005-2024 yuanmayuan.com 【源码园】 版权所有 备案信息

声明: 本站非腾讯QQ官方网站 所有软件和文章来自互联网 如有异议 请与本站联系 本站为非赢利性网站 不接受任何赞助和广告