引言

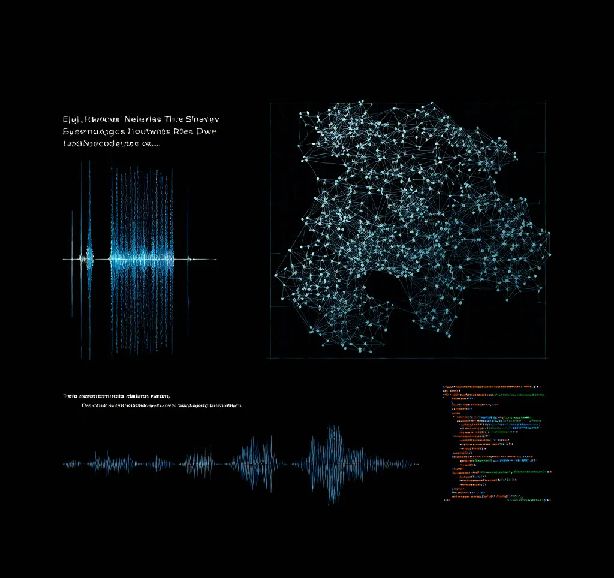

在人工智能的快速发展中,语音合成技术已经成为一项不可或缺的创新工具。特别是基于神经网络的语音合成,不仅提高了语音的自然度和逼真度,还为人机交互提供了新的可能性。本文将深入探讨神经网络在语音合成中的应用,并详细介绍从研究到部署的全过程。

神经网络语音合成的技术背景

语音合成技术的核心在于将文本转换为可理解的语音输出。传统的方法依赖于规则和拼接技术,而神经网络的引入,特别是深度学习模型的应用,使得语音合成进入了一个新的时代。Tacotron2和WaveNet等模型的出现,标志着语音合成技术的重大突破。

Tacotron2模型详解

Tacotron2模型是端到端语音合成的代表作,它通过一个复杂的神经网络架构,直接从文本生成语音波形。模型的结构包括:

WaveNet模型的作用

WaveNet模型在语音合成中扮演着关键角色,它通过生成高质量的语音波形,提升了合成语音的自然度和清晰度。WaveNet使用了一种称为扩张卷积(dilated convolution)的技术,能够捕捉到语音信号中的微妙变化。

部署过程

数据准备:

import librosa

import numpy as np

def preprocess_audio(audio_file):

audio, sr = librosa.load(audio_file, sr=None)

frames = librosa.util.frame(audio, frame_length=1024, hop_length=512)

mel_spectrogram = librosa.feature.melspectrogram(frames, sr=sr, n_mels=80)

return mel_spectrogram

模型训练:

import tensorflow as tf

from tacotron2 import Tacotron2

model = Tacotron2()

optimizer = tf.keras.optimizers.Adam(learning_rate=0.001)

def mel_spectrogram_loss(y_true, y_pred):

return tf.keras.losses.mean_squared_error(y_true, y_pred)

model.compile(optimizer=optimizer, loss=mel_spectrogram_loss)

model.fit(train_data, epochs=20, batch_size=32)

模型集成:

def synthesize_text(text):

mel_spectrogram = tacotron2_model.predict(text_to_mel_spectrogram(text))

audio_waveform = wavenet_model.predict(mel_spectrogram)

return audio_waveform

未来发展方向

结论

神经网络在语音合成领域的应用,不仅提升了技术的性能,还开辟了新的研究和应用领域。通过Tacotron2和WaveNet的结合,我们能够实现高质量的语音合成系统,未来在多说话人合成、自适应和实时合成等方面仍有巨大的发展空间。

结语

本文通过对神经网络语音合成技术的全面介绍,旨在为读者提供从理论到实践的深入理解。无论是技术人员还是研究者,都能从中获得启发,推动语音合成技术的进一步发展和应用。

声明:

1、本博客不从事任何主机及服务器租赁业务,不参与任何交易,也绝非中介。博客内容仅记录博主个人感兴趣的服务器测评结果及一些服务器相关的优惠活动,信息均摘自网络或来自服务商主动提供;所以对本博客提及的内容不作直接、间接、法定、约定的保证,博客内容也不具备任何参考价值及引导作用,访问者需自行甄别。

2、访问本博客请务必遵守有关互联网的相关法律、规定与规则;不能利用本博客所提及的内容从事任何违法、违规操作;否则造成的一切后果由访问者自行承担。

3、未成年人及不能独立承担法律责任的个人及群体请勿访问本博客。

4、一旦您访问本博客,即表示您已经知晓并接受了以上声明通告。

本站资源仅供个人学习交流,请于下载后24小时内删除,不允许用于商业用途,否则法律问题自行承担。

Copyright 2005-2024 yuanmayuan.com 【源码园】 版权所有 备案信息

声明: 本站非腾讯QQ官方网站 所有软件和文章来自互联网 如有异议 请与本站联系 本站为非赢利性网站 不接受任何赞助和广告