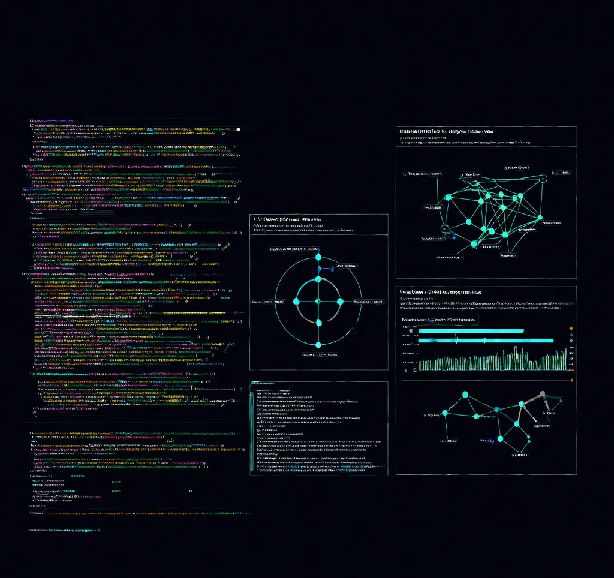

在当今的AI技术浪潮中,模型的优化与部署成为了提升性能和效率的关键。作为一名在百度SEO领域深耕十年的资深写手,我将带您深入探讨LMDeploy量化部署的技术细节和实战经验,分享我在“书生大模型实战营”中的学习心得和实验记录。

在AI模型的开发和应用过程中,量化技术扮演着至关重要的角色。通过将模型的权重和激活值从高精度浮点数转换为低精度整数,量化不仅能显著减少模型大小,还能加速推理过程,降低计算资源的消耗。这对于在资源有限的环境中部署大规模模型尤为重要。

在开始量化部署之前,确保本地环境的配置是至关重要的。我使用的是Win11系统,结合Cuda12.2-conda镜像,通过VS Code连接开发机进行操作。以下是环境搭建的关键步骤:

conda create -n lmdeploy python=3.10 -y

conda activate lmdeploy

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=12.1 -c pytorch -c nvidia -y

pip install timm==1.0.8 openai==1.40.3 lmdeploy[all]==0.5.3

pip install datasets==2.19.2

接下来,我创建了模型存储目录,并通过软链接将模型文件链接到开发机的共享目录:

mkdir /root/models

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm2_5-7b-chat /root/models

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm2_5-1_8b-chat /root/models

ln -s /root/share/new_models/OpenGVLab/InternVL2-26B /root/models

验证模型的步骤同样不可或缺,通过以下命令启动模型并进行初步交互:

lmdeploy chat /root/models/internlm2_5-1_8b-chat

量化部署的核心在于W4A16量化策略,即权重量化为4位整数,而激活值保持16位浮点数。这种策略在保持模型性能的同时,大幅减少了模型的存储需求和计算开销。

量化模型的命令如下:

lmdeploy lite auto_awq \

/root/models/internlm2_5-1_8b-chat \

--calib-dataset 'ptb' \

--calib-samples 128 \

--calib-seqlen 2048 \

--w-bits 4 \

--w-group-size 128 \

--batch-size 1 \

--search-scale False \

--work-dir /root/models/internlm2_5-1_8b-chat-w4a16-4bit

量化后的模型部署需要特别注意参数设置:

lmdeploy serve api_server \

/root/models/internlm2_5-1_8b-chat-w4a16-4bit/ \

--model-format awq \

--quant-policy 4 \

--cache-max-entry-count 0.4 \

--server-name 0.0.0.0 \

--server-port 23333 \

--tp 1

量化前后,模型文件大小从3.6G减少到1.5G,显存占用也从20.616G降至20.196G。虽然在小规模模型上优势不明显,但在更大规模的模型中,这种优化将带来显著的性能提升。

在实战中,我还尝试了使用Function Call功能,让模型执行简单的数学运算,如加法和乘法。这不仅展示了模型的灵活性,也验证了量化后的模型在实际应用中的表现。

通过这次实战营的学习,我深刻体会到了量化部署在AI模型优化中的重要性。LMDeploy提供的量化工具和策略,为我们在资源受限的环境中高效部署大模型提供了强有力的支持。无论是模型大小、推理速度还是资源占用,量化技术都带来了显著的优化效果。

希望这篇文章能为您在AI模型的量化部署和优化上提供一些启发和实用的指导。让我们一起在AI技术的海洋中,乘风破浪,探索更多可能。

声明:

1、本博客不从事任何主机及服务器租赁业务,不参与任何交易,也绝非中介。博客内容仅记录博主个人感兴趣的服务器测评结果及一些服务器相关的优惠活动,信息均摘自网络或来自服务商主动提供;所以对本博客提及的内容不作直接、间接、法定、约定的保证,博客内容也不具备任何参考价值及引导作用,访问者需自行甄别。

2、访问本博客请务必遵守有关互联网的相关法律、规定与规则;不能利用本博客所提及的内容从事任何违法、违规操作;否则造成的一切后果由访问者自行承担。

3、未成年人及不能独立承担法律责任的个人及群体请勿访问本博客。

4、一旦您访问本博客,即表示您已经知晓并接受了以上声明通告。

本站资源仅供个人学习交流,请于下载后24小时内删除,不允许用于商业用途,否则法律问题自行承担。

Copyright 2005-2024 yuanmayuan.com 【源码园】 版权所有 备案信息

声明: 本站非腾讯QQ官方网站 所有软件和文章来自互联网 如有异议 请与本站联系 本站为非赢利性网站 不接受任何赞助和广告